La talentueuse compagnie L’unijambiste présentera sa prochaine production “Le songe d’une nuit d’été” (de W. Shakespeare traduit par A. Markowicz et F. Morvan) à partir de mi-janvier 2012 dans les théatres français.

Vous l’aurez compris votre serviteur fait partie de la sympathique équipe qui va préparer cette création.

Dans les mille et une surprises qui attendent le public je parlerais aujourd’hui de celle qui est déjà un peu disponible sous la forme d’une application pour téléphone portable.

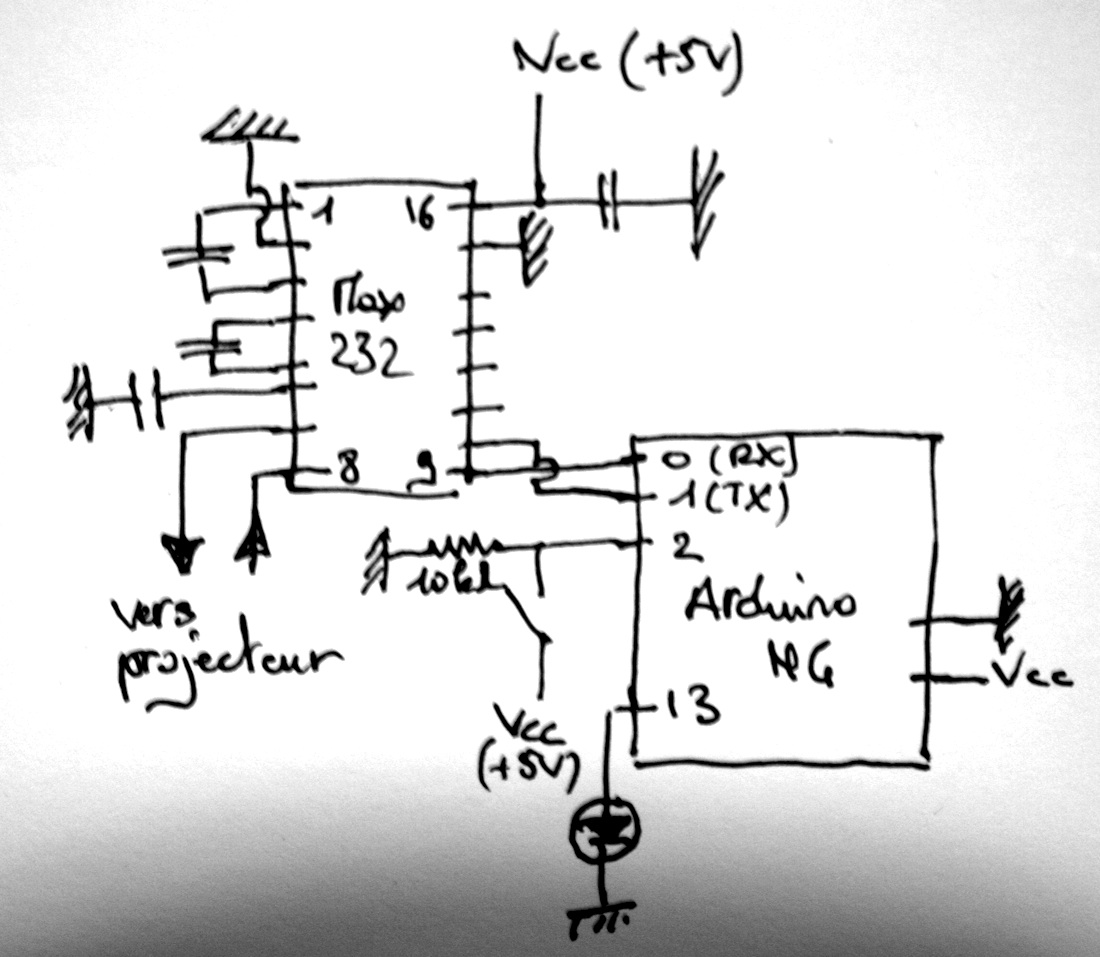

Lors de nos premiers échanges et recherches d’idées pour cette création j’avais évoqué une technique (ou technologie comme on veut) permettant de jouer des morceaux avec des dés. Je disais qu’il suffit de tourner le dés, d’en dévoiler une autre face pour qu’une nouvelle ligne de basse soit lue ou qu’une nouvelle mélodie soit entendue. J’ai fait les premiers essais en utilisant tout d’abord les symboles fiduciaires de Reactivision, un excellent programme permettant de faire de l’identification de symboles à l’aide d’une caméra numérique.

Lors d’un premier atelier, Robert le Magnifique (qui compose la musique de ce spectacle) avait concocté un petit set que nous nous sommes mis à manipuler avec des dés en bois, d’environ 5 cm de coté sur les faces desquels nous avions collés les fiduciaires de Reactivision. Reactivision envoie des informations à Max5 qui, lui même, commande Live.

Cette vidéo vous permettra sans doute d’en comprendre les principes.

Pas satisfait de l’esthétique des symboles et ayant des doutes sur la robustesse de la détection des fiduciaires (dans des conditions de tournée) j’ai choisi de développer une application sachant détecter des symboles plus simples : les symboles utilisés en réalité augmentée (marqueur BCH).

J’ai donc développer une application en C++ en me servant d’Openframeworks et d’ARToolkitPlus.

Tout ça est un peu technique, mais très simple au final : vous avez sans doute déjà rencontré des QR codes ou des codes barres. Ces deux types de symboles font la même chose : ils associent une information complexe (le nom d’un produit, sa traçabilité, son prix, …) à un symbole. Par lecture du code à l’aide d’un interpréteur, on obtient les informations contenues dans le symbole (c’est ce qui se fait en caisse des magasins). Les QR codes (un exemple est donné en fin d’article) sont un peu plus complexes et permettent de stocker plus d’informations. Les codes que nous utilisons sont simples et permettent juste d’être distingués les uns des autres.

Vous aurez, j’espère, l’occasion de venir voir fonctionner ce concept lors de notre tournée.

Dans la continuité de cette idée nous avions l’envie de prolonger cette manière de déclencher la lecture d’un média numérique en proposant une expérience de “flash code” un peu spécifique au projet, permettant d’accéder à des informations inédites sur notre création, des making off que nous n’aurions pas forcément l’occasion de faire partager, …

Nous avons donc créé le symbole suivant que vous pourrez voir dans les plaquettes des théatres où nous sommes programmés.

J’ai développé Flash Cube une application pour téléphone Android qui permet en filmant ce symbole d’être renvoyé sur une page du site de L’unijambiste où vous pourrez voir ces informations inédites. Cette page étant conçue comme un journal, son contenu change fréquemment.

Cette application est surtout l’occasion de faire pratiquer à notre futur public (ou une partie) le concept que nous utilisons pour jouer la musique (et bien d’autres surprises) dans notre nouvelle création.

Le code ci-dessous est cliquable à partir d’un téléphone Android et permet de récupérer, sur le market Android, l’application.

Pour ce qui est du code, j’ai utilisé Andar, une librairie Java de réalité augmentée. Le développement a été réalisé entièrement en Java sous Eclipse. Comme je l’expliquerai dans un prochain post, Processing permet de développer de manière plus simple une application sous Android mais n’offre pas toutes les possibilités du SDK Android.